梦晨 发自 凹非寺量子位 | 公众号 QbitAI

关于ChatGPT变笨原因,学术界又有了一种新诠释。

加州大学圣克鲁兹分校一项连络指出:

在磨砺数据适度之前的任务上,大模子进展彰着更好。

论文重心连络了“任务抵制”问题,也便是大模子在磨砺时间就办法过许多任务示例,给东说念主一种AI领有零样本或少样本智商的诞妄印象。

也有学者从另一个角度指出,大模子磨砺后参数冻结,东说念主们不停建议新的任务也便是输入分手不停变化。如若模子不成不停符合这种变化,就进展成智商迟缓退化。

东说念主们以为只提了个问题AI就能回应,其实是在磨砺时见过大精深常见任务。

随时候推移,东说念主们运行建议更多新问题,AI进展就不行了。

比如关于代码问题,编程话语还在执续发展变化,晨夕有一天后果会低到不可接受。

这是总共不具备执续学习智商模子的运说念。

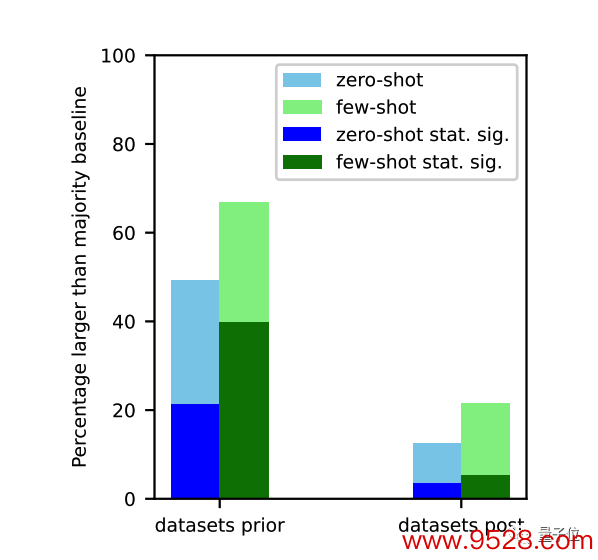

任务抵制有多严重?

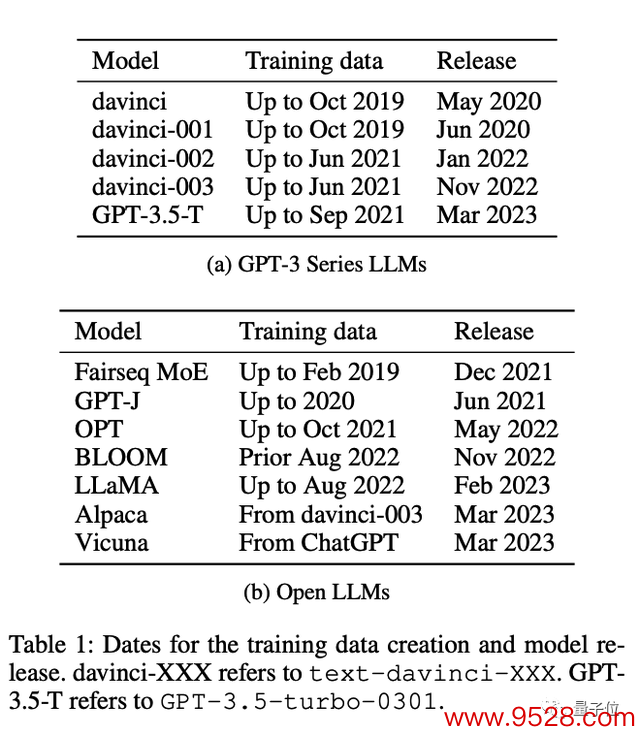

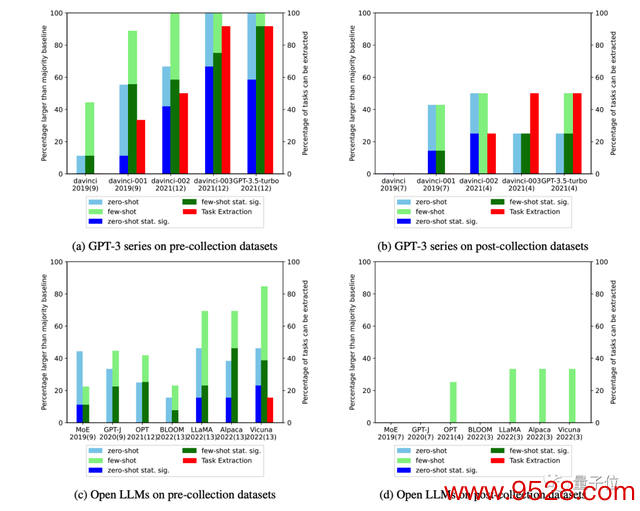

连络团队一共评估了12种模子,从ChatGPT之前的GPT-3系列、OPT、Bloom,到最新的GPT-3.5-turbo、羊驼家眷Llama、Alpaca和Vicuna等。

它们齐存在访佛问题,也便是在磨砺适度之前的任务上进展彰着更好。

评估任务抵制极端繁重,闭源模子根蒂不会公布磨砺数据,大精深开源模子也仅仅人命了着手,而不发布数据自身。

如若连络者再行爬取互联网数据,也有可能与模子磨砺时比较发生了变化。

对此,团队秉承4种纪律来测量任务抵制进度:

检讨磨砺数据:平直搜索有莫得相应的任务示例

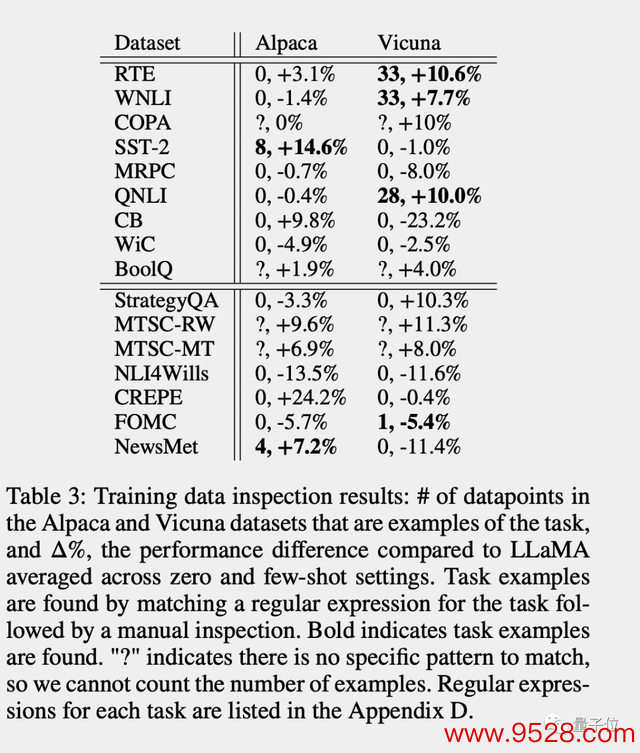

在开源模子Alpaca和Vicuna上,存在磨砺数据抵制的任务进展就比原版Llama更好的趋势彰着。

提真金不怕火任务示例:通过转念教导词,让模子我方把磨砺数据中的任务示例背出来

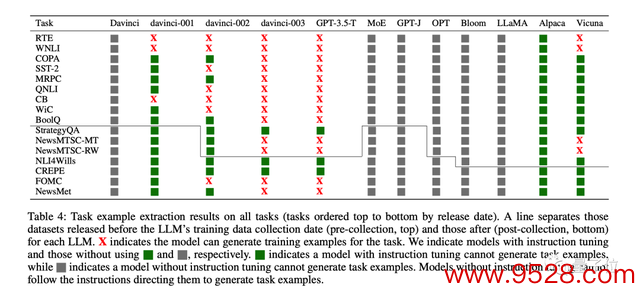

从GPT-3 davinci-001版块到GPT-3.5-Turbo,这个问题越来越严重了。

图中X代表模子复述出了磨砺数据数据中的原始任务示例,绿色代表过程指示微调的模子莫得复述磨砺数据。

灰色代表未过程指示微调的模子无法根据教导词教授复述磨砺数据,但不代表问题不存在。

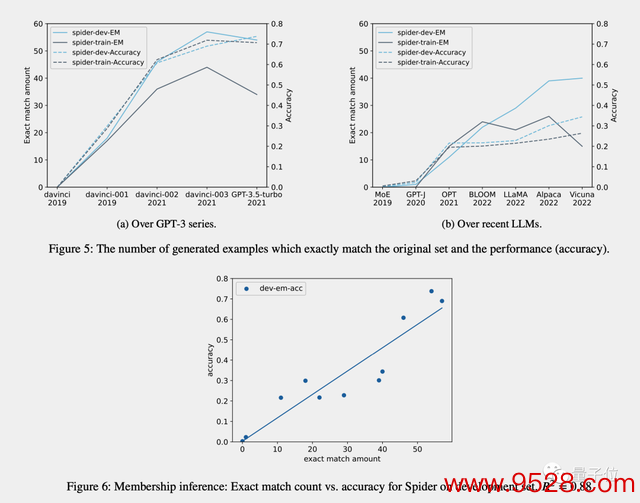

成员算计(只适用于生成任务):检讨模子生成的谜底是否与原始数据全齐调换

依时候端正分析:关于已知磨砺数据汇注时候的模子,测量已知发布时候数据集上的进展并使用依时候端正的凭证检讨数据抵制凭证

前三种纪律精度较高,但调回率较低。如若在职务的磨砺数据中找到数据,则不错详情它如故看到了示例。

但由于数据方式的变化、关键字的变化以及数据集的大小,使用前三种纪律莫得找到凭证并不虞味着数据抵制不存在。

第四种纪律调回率高但精度低,容易受干涉成分影响。

特出是关于GPT-3系列,当今东说念主们假定其智商普及来自于指示微调,但连络团队以为事实并非如斯。

诚然在2021年之前的数据集上,davinci-002比davinci-001的性能有所普及,但在2021年之后的数据集上性能却相应下落,

通这标明GPT-3系列的指示微调只适用于某些早期数据集。

终末团队的论断为:

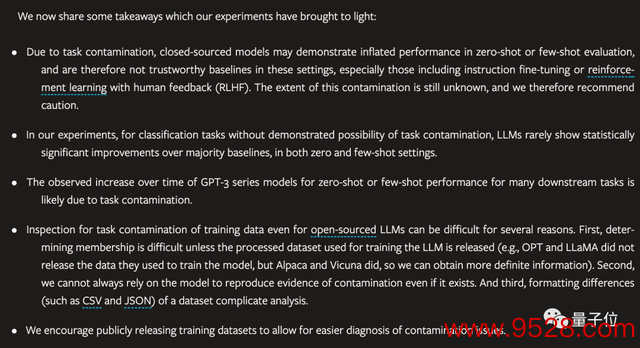

由于任务抵制,闭源模子可能会在零样本或少样本评估中进展的比内容好,特出是过程RLHF微调的模子。抵制的进度仍不明晰,因此咱们建议审慎行事。在实验中,关于莫得任务抵制可能性的分类任务,大模子很少在零样本和少样本设立中进展出联系于大精深基线具有统计学兴味的显耀阅兵。跟着时候推移,不雅察到GPT-3系列模子在许多卑劣任务的的零样本或少样人性能有所增多,这可能是由于任务抵制酿成的。即使关于开源模子,检讨磨砺数据的任务抵制也很繁重。饱读舞公开垦布磨砺数据,以便检讨任务抵制问题。

有东说念主回顾到:

用现存数据磨砺AI东说念主们过多使用AI,甚至于改革了执行寰宇AI无法符合改革后的寰宇,变得低效

这是一个轮回。

论文:https://arxiv.org/abs/2312.16337

参考集会:[1]https://twitter.com/ChombaBupe/status/1741531065032798360